3D 모델 렌더링은 AI에 의해 대체 가능한가?

AI의 급부상

최근 Open Ai의 chat GPT 및 DALL-E 2를 비롯해 Stable Diffusion 등 다양한 인공지능 서비스 들이 쏟아져 나오면서 세상이 정말 급격하게 변하고 있음을 느낀다. 기술이 발전하는 속도가 문득 체감 될 때마다 금세 뒤처질 것 같은 불안감과 함께 섬뜩함이 들고는 한다.

chat GPT는 이미 내 일상에 깊이 자리 잡아서 대부분의 일을 할 때 사용하고 있다. chat GPT를 사용할 때와 사용하지 않을 때의 생산성 격차가 너무 커서 사용하지 않을 수 없다. 최근에는 개인 프로젝트로 웹 서비스를 만들어서 배포했는데 chat GPT의 공헌이 컸다.

서비스 기획의 큰 틀은 이미 내 머리에 있었지만 기획적 부분의 맥락을 다듬는데 도움이 되었고, 무엇보다 코드를 작성할 때 큰 도움을 받았다. 내가 개발을 전문적으로 배운 게 아니라 개인적으로 공부하면서 작업을 했기 때문에 전문 지식과 기술이 많이 부족했는데, 개발 과정에 문제가 생길 때마다 돌파구를 제시해줬다. 서비스의 최소 기능 제품이 완성되기까지 개발 과정이 3일 정도 걸렸는데, chat GPT를 사용하지 않았더라면 적어도 일주일은 지나서 완성했을 것이다.

3D 모델의 렌더링을 AI가 대체할 수 있을까

최근에는 AI 이미지 생성 서비스인 DALL-E 2와 midjourney를 접한 뒤로 '이 기술이 렌더링 분야에도 적용될 수 있을까?'라는 생각이 한동안 머릿속을 맴돌던 궁금한 내용이었다. 얼마 전에 해당 서비스들이 Diffusion 모델을 토대로 제작된 서비스라는 정보를 알게 되었고 Stable Diffusion이라는 오픈소스 기술도 존재한다는 사실을 알게 되었다.

마침 전날 친구와 '건축 렌더링 분야를 AI가 대체하기까지 얼마나 남았을까'라는 얘기를 한 터라 곧바로 구글 CoLab을 통해 Stable Diffusion을 접해봤는데 아직 숙련도가 낮아서 결과물을 만들기는 어려웠지만 몇 가지 정보들을 찾아보니 충분히 가능할 법도 한 것 같았다.

조금 사용해보니 정해진 시나리오를 따라가는 애니메이션의 경우 향후 몇 년 내로 3D모델 없이 단편 작품 정도는 출현할 수 있을 것 같다는 생각이 들었다. 나머지 제품이나 건축처럼 3D모델은 AI가 손 보는 부분 없이 완벽하게 유지된 상태로 실사 렌더링을 걸어야 하는 부분이라면 어떻게 될 지 모르겠는데 분명 머지않아 완벽하게 수행할 날이 오지 않을까 가늠해본다.

시간이 나는 대로 건축 및 제품의 3D모델의 렌더링을 현재 Diffusion 모델의 AI로 대체할 수 있는지 공부하고 테스트해봐야겠다. 진행하면서 새로 알게 되는 정보들은 이 블로그에서 공유하도록 할 것이다.

AI를 이용한 건축 3D렌더링 테스트

stable diffusion을 이용해 ai를 이용해 건축 3D 렌더링의 가능성에 대해 테스트해보려고 한다.

|

| 언스플래쉬 이미지 |

지금은 직접 3D 모델링을 사용하지는 않고 오픈소스 이미지를 구해와서 변형을 시킨다.

|

| Stable Diffusion Web UI 화면 |

구글 코랩에서 지원하는 Stable Diffusion Web UI를 활용했다.

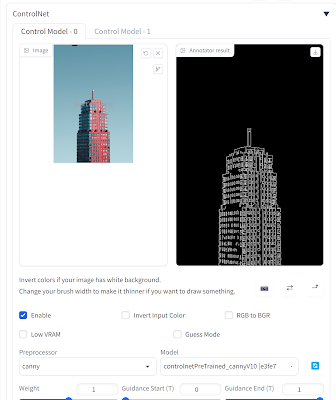

컨트롤넷의 cany라는 Preprocessor를 이용하면 이미지 속 화면의 우측처럼 아웃라인을 추출해준다.

|

| stable diffusion을 사용해 만든 렌더링 과정 |

첫 번째 사진을 컨트롤넷을 이용해 라인을 추출해 두 번째 이미지를 만들었다.

세 번째, 네 번째 사진은 프롬프트에 하얀 콘크리트 빌딩을 입력한 결과이고, 다섯 번째와 여섯 번째는 커튼월 빌딩을 입력한 결과이다.

조금 더 공부하면서 시도를 해보고 나중에 3D모델을 직접 사용해서 의미 있는 수준의 렌더링을 만드는 방법을 공유하도록 하겠다.

댓글

댓글 쓰기